在數據中臺體系中,數據處理服務是連接原始數據與數據價值的關鍵樞紐,其核心目標正是“讓數據用起來”。本文基于數據中臺前四章的核心理念,聚焦數據處理服務,梳理關鍵筆記與心得。

第一章:從數據孤島到數據服務化

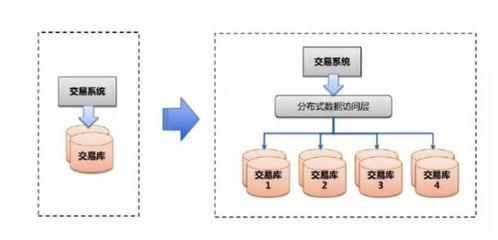

數據處理服務的起點,是打破煙囪式系統形成的數據孤島。這一階段的核心任務是統一接入與標準化。筆記要點包括:1) 建立統一的數據接入層,支持多源異構數據(數據庫日志、前端埋點、第三方API等)的實時與批量攝入;2) 制定企業級數據標準與模型(如維度建模),在接入時即進行初步的規范化和清洗,為后續處理奠定一致性的基礎。關鍵在于,數據處理服務在此階段不應僅是技術管道,更應承載業務語義,明確每個數據字段的業務歸屬與定義。

第二章:數據加工與質量治理流水線

原始數據標準化后,便進入核心的加工環節。本章重點在于構建可復用、可監控的數據處理流水線。筆記核心:1) 分層加工:采用ODS(操作數據層)、DWD(明細數據層)、DWS(匯總數據層)、ADS(應用數據層)等經典分層模型,逐層抽象,降低復雜度,提高復用性。數據處理服務需為每一層提供清晰的轉換邏輯模板。2) 質量嵌入:在每一個處理環節(如清洗、關聯、聚合)內置質量校驗規則(如完整性、一致性、準確性檢查),并實現血統追溯,確保問題數據可定位、可回溯。數據處理服務應提供質量度量的實時反饋。

第三章:計算存儲與任務調度引擎

本章關注數據處理服務賴以運行的技術基礎設施。筆記要點:1) 計算引擎選型與融合:根據處理場景(批量ETL、實時流處理、交互式查詢、機器學習)選擇合適的計算框架(如Spark、Flink、Trino/Presto),并通過統一服務層進行封裝,對上層提供透明化的計算能力。2) 任務調度與依賴管理:構建健壯的任務調度系統(如DolphinScheduler、Airflow),清晰定義數據處理任務間的依賴關系、執行周期和優先級,確保數據處理流水線有序、高效、自動地運轉。關鍵是以服務化的方式對外提供任務編排、監控告警能力。

第四章:服務化封裝與API管理

經過處理的高質量數據,最終需要通過服務化的方式交付,才能真正“用起來”。這是數據處理服務的價值出口。本章筆記核心:1) 數據服務封裝:將處理后的數據(尤其是ADS層或專題數據模型)封裝成標準的、可理解的數據API、數據查詢服務或推數服務。服務需具備清晰的接口契約、文檔和版本管理。2) 統一服務管理與運營:建立數據服務網關,負責服務的注冊、發現、授權、限流、監控和計量。目標是讓業務方(如前端應用、分析人員)能夠像使用普通微服務一樣,便捷、安全、穩定地消費數據,從而將數據能力快速轉化為業務創新。

**

數據處理服務是數據中臺的能力工廠,它貫穿了數據從“原材料”到“標準化半成品”再到“可交付數據產品”的全過程。前四章的核心脈絡可概括為:統一接入定標準 -> 分層加工保質量 -> 高效調度強支撐 -> 服務封裝促消費**。其成功的關鍵在于,始終以業務價值為導向,通過標準化、自動化、服務化的手段,將復雜的數據處理技術細節封裝成穩定、易用的數據能力,最終賦能業務,真正做到“讓數據用起來”。